- 1. 请解释 Android Framework 中的音频架构。它由哪些组件组成,每个组件的作用是什么?

- 2. 什么是采样和采样率?

- 3. 什么是采样位数/位宽?

- 4. 什么是声道?

- 5. 什么是音轨?

- 6. Android 中的音频功能由哪些类和接口提供支持?请列举一些关键的类和接口,并解释它们的作用。

- 7. 什么是音频焦点(Audio Focus)?它在 Android 中的应用场景是什么?如何请求和管理音频焦点?

- 8. Android 有哪些音频焦点的类型?

- 9. Android 中的音频播放器和音频录制器都有哪些类和接口?它们之间的主要区别是什么?

- 10. 如何在 Android 应用程序中播放音频文件?请描述播放音频的基本步骤和使用哪些类和方法。

- 11. 如何实现音频的录制功能?请描述录制音频的基本步骤和使用哪些类和方法。

- 12. 什么是音频编解码(Audio Encoding/Decoding)?Android 中支持哪些音频编解码器?请举例说明如何使用音频编解码器进行编解码操作。

- 13. Android 提供了哪些音频效果和音频处理功能?例如,回声消除、噪声抑制、均衡器等。请举例说明如何应用这些音频效果。

- 14. 请解释 Android 中的音频路由(Audio Routing)是什么,并举例说明如何控制音频的路由。

- 15. 音频延迟对于实时应用程序(如语音通话、游戏)非常重要。在 Android 中,如何测量和降低音频延迟?

- 16. Android 中如何处理音频焦点冲突?如果应用程序正在播放音频而另一个应用程序请求音频焦点,该怎么办?

- 17. 什么是音频混音(Audio Mixing)?Android 中如何实现多个音频源的混音?

- 18. 在 Android 中,如何实现音频的跨应用共享?例如,一个应用程序可以播放音频,而另一个应用程序可以接收并处理该音频。

- 19. Android 提供了哪些音频格式支持?如何在应用程序中识别和处理不同的音频格式?

- 20. 如何在 Android 应用程序中实现音频的实时处理和实时效果?

- 21. 请解释 Android 中的音频回放(Audio Playback)和音频流(Audio Stream)之间的区别和联系。

- 22. Android 中的音频通道(Audio Channel)是什么?不同的音频通道有什么作用?

- 23. Android 中的音频事件(Audio Events)是什么?可以举例说明几种常见的音频事件。

- 24. Android 中的音频录制和播放涉及到的底层音频硬件是什么?如何与音频硬件进行交互?

- 25. 在 Android 中如何处理音频延迟和音频时钟同步的问题?

- 26. Android Framework 中 Binder 在 Audio 模块中的作用

- 27. AOSP 源码中跟 audio 相关的代码路径

1. 请解释 Android Framework 中的音频架构。它由哪些组件组成,每个组件的作用是什么?

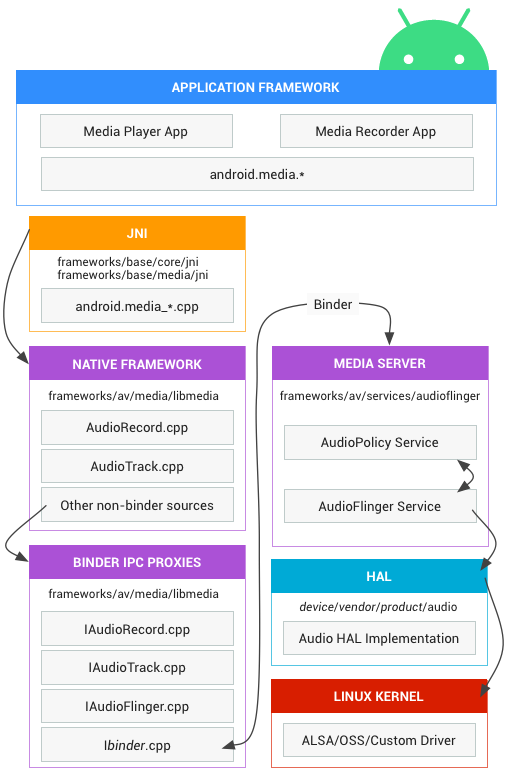

Android Framework 中的音频架构由多个组件组成,每个组件承担着不同的角色和功能。以下是 Android Framework 中的主要音频组件及其作用:

AudioFlinger:AudioFlinger 是 Android 音频系统的核心组件,它负责协调和管理音频数据的流动。它作为音频服务的主要组件,管理着音频输入和输出流的路由、混合和处理。它负责将来自不同应用程序和音频源的音频数据进行混合、处理和输出,并确保音频的流畅播放。

AudioPolicyManager:AudioPolicyManager 是音频策略管理器,负责管理音频策略和音频焦点。它定义了音频策略的规则和优先级,根据应用程序的需求来分配音频焦点。它还负责处理音频焦点的变化,根据策略进行音频路由和混合,并确保正确的音频行为和用户体验。

AudioManager:AudioManager 提供了对音频系统的控制和管理。它是应用程序与音频系统交互的接口,可以用于获取和设置音频属性,如音量控制、音频模式和音频路由。它还提供了与音频焦点相关的方法,用于管理应用程序之间的音频焦点请求和转移。

AudioTrack 和 AudioRecord:AudioTrack 和 AudioRecord 是用于音频播放和录制的关键类。AudioTrack 负责将音频数据写入音频输出设备(如扬声器或耳机),实现音频的播放功能。AudioRecord 负责从音频输入设备(如麦克风)中读取音频数据,实现音频的录制功能。

AudioEffects API:AudioEffects API 提供了一套用于音频效果处理的接口,可以对音频数据进行混响、均衡器、压缩等处理。通过 AudioEffects API,应用程序可以实现对音频数据的实时处理,以增强音频效果和用户体验。

MediaCodec 和 MediaPlayer:MediaCodec 和 MediaPlayer 是用于音视频编解码和播放的类。它们与音频密切相关,负责解码和播放音频数据。MediaCodec 提供了底层的音频编解码功能,而 MediaPlayer 是一个高级的音视频播放器,提供了更高层次的音频控制和管理。

这些组件共同构成了 Android Framework 中的音频架构,实现了音频输入、输出、处理、管理和控制的功能。通过这些组件,Android 应用程序可以实现音频录制、播放、效果处理和音频系统的控制与管理。

2. 什么是采样和采样率?

声音从模拟信号(连续的)变成数字信号(离散的),这个过程叫做采样。 每秒钟的采样次数称为采样频率。 采样频率越高,越接近原始信号。16000Hz 和 44.1kHz。

3. 什么是采样位数/位宽?

数字信号是用 0 和 1 来表示的。采样位数就是采样值用多少位 0 和 1 来表示,也叫采样精度,用的位数越多就越接近真实声音。如用 8 位表示,采样值取值范围就是 -128 ~ 127,如用 16 位表示,采样值取值范围就是 -32768 ~ 32767。

4. 什么是声道?

声道(Channel)是指音频信号中的独立音轨或声音源的分离和播放。每个声道承载着特定的音频信息,例如左声道和右声道分别用于立体声音频,而中央声道用于处理语音信号或重要音频元素。

在音频领域,常见的声道配置包括以下几种:

- 单声道(Mono):只有一个声道,所有音频信息都混合在一起。

- 立体声(Stereo):左声道和右声道分别承载左右声音信息,用于提供立体感觉的音频效果。

- 5.1 声道(5.1 Surround):包括前置左声道、前置中央声道、前置右声道、后置左声道、后置右声道和低音炮声道(LFE,Low-Frequency Effects),用于提供环绕音效的多声道音频。

- 7.1 声道(7.1 Surround):基于 5.1 声道扩展,增加了两个额外的后置声道,提供更加真实的环绕音效。

不同的声道配置可以提供更加丰富和逼真的音频体验,适用于不同类型的媒体内容和音频场景。音频设备和系统通常支持不同声道配置的播放和处理。

5. 什么是音轨?

音轨(Audio Track)是指音频数据在时间轴上的一个单独的实体,代表了一段特定的音频内容。在音频处理和播放中,音频数据可以分为多个音轨进行管理和处理。

音轨通常用于多声道音频的播放和混音,每个音轨对应于一个独立的声道或音频源。不同音轨的音频数据可以通过混音或叠加的方式合并到最终的音频输出中。

在多媒体应用和编辑软件中,音轨常用于组织和编辑音频内容。每个音轨可以包含不同的音频片段,可以进行剪辑、淡入淡出、音量调节等操作。通过对音轨的编辑和控制,可以实现音频的创作、混音和后期处理。

音轨在音频处理和播放中起到了重要的作用,它们使得多个音频源可以同时存在并进行独立的处理,提供了更加灵活和丰富的音频表现方式。

6. Android 中的音频功能由哪些类和接口提供支持?请列举一些关键的类和接口,并解释它们的作用。

在 Android 中,音频功能由以下关键类和接口提供支持:

AudioManager:AudioManager 类用于管理音频系统,提供了音量控制、音频模式设置、音频路由管理等功能。它可以获取和设置音频属性,并处理音频焦点的请求和转移。

AudioTrack:AudioTrack 类用于播放音频数据。它提供了创建和管理音频输出的功能,可以将音频数据写入音频输出设备(如扬声器或耳机)。通过设置采样率、声道数、音频格式等参数,可以实现音频的播放。

AudioRecord:AudioRecord 类用于录制音频数据。它提供了从音频输入设备(如麦克风)读取音频数据的功能。可以设置采样率、声道数、音频格式等参数,并使用缓冲区进行音频数据的处理和读取。

AudioEffect:AudioEffect 类是音频效果处理的基类,用于对音频数据进行实时处理。它提供了一套接口,可以实现音频效果处理,如混响、均衡器、压缩等。应用程序可以通过 AudioEffect 类来添加和管理音频效果。

MediaPlayer:MediaPlayer 类是一个高级的音视频播放器,提供了播放音频和视频的功能。它封装了底层的音视频处理和控制,提供了更高层次的接口和方法,支持播放本地和网络上的音频文件。

AudioAttributes:AudioAttributes 类用于指定音频数据的属性,如音频流类型、音频用途和音频标志。它可以帮助配置和定义音频数据的特性,以便系统正确处理和路由音频。

这些类和接口提供了丰富的功能和方法,用于实现音频的录制、播放、处理和管理。开发人员可以利用这些类和接口来创建音频应用程序,并实现各种音频功能,如音乐播放器、语音通话应用等。

7. 什么是音频焦点(Audio Focus)?它在 Android 中的应用场景是什么?如何请求和管理音频焦点?

音频焦点(Audio Focus)是指在 Android 系统中,控制和管理应用程序之间音频资源的分配和使用的机制。它用于确保在多个应用程序同时请求音频资源时,系统可以根据优先级和需求分配适当的音频资源,以提供更好的用户体验。

应用场景:

音乐播放器:当用户正在使用音乐播放器播放音乐时,来电或其他应用程序请求音频焦点时,音乐播放器会暂停播放,让其他应用程序使用音频资源,以确保来电铃声或其他应用程序的声音可以被听到。

语音通话:在进行语音通话时,系统会优先分配音频焦点给通话应用,以确保通话的质量和可靠性。其他应用程序会暂停或降低音量,以避免干扰通话。

游戏应用:在游戏应用中,当来电或其他音频事件发生时,游戏应用可以请求短暂的焦点损失,以允许其他音频事件播放,并在完成后恢复焦点,以继续游戏音效的播放。

请求和管理音频焦点的步骤:

请求音频焦点:应用程序通过 AudioManager 请求音频焦点,指定焦点类型和焦点变化时的回调接口。

处理焦点变化回调:应用程序实现焦点变化回调接口,处理焦点的变化情况,如焦点获得、焦点暂时失去、焦点永久失去等。

与其他应用程序协调:应用程序在处理焦点变化时,需要与其他应用程序协调,如暂停播放、降低音量或停止音频播放等操作。

释放音频焦点:当应用程序不再需要音频焦点时,应该及时释放焦点,以便其他应用程序可以获得焦点并使用音频资源。

通过请求和管理音频焦点,Android 系统可以实现应用程序之间对音频资源的合理分配和控制,提供更好的用户体验和音频行为的协调。

8. Android 有哪些音频焦点的类型?

Android 音频焦点(Audio Focus)的类型如下:

AUDIOFOCUS_GAIN:表示请求获得持久性的音频焦点,用于长时间播放音频,例如音乐播放器。

AUDIOFOCUS_GAIN_TRANSIENT:表示请求获得临时性的音频焦点,用于短时间播放音频,例如提示音效或短通知声。

AUDIOFOCUS_GAIN_TRANSIENT_MAY_DUCK:表示请求获得临时性的音频焦点,并且允许其他应用以降低音量的方式播放音频,例如在播放音乐时收到来电铃声。

AUDIOFOCUS_LOSS:表示失去音频焦点,需要停止播放音频。

AUDIOFOCUS_LOSS_TRANSIENT:表示暂时失去音频焦点,但是稍后可能会重新获得焦点,例如在来电时暂停音乐播放。

AUDIOFOCUS_LOSS_TRANSIENT_CAN_DUCK:表示暂时失去音频焦点,但允许继续以降低音量的方式播放音频。

应用程序可以根据自身的需求选择适合的音频焦点类型来管理音频播放行为。根据焦点类型的不同,系统会采取相应的策略,例如暂停、降低音量或停止播放。

9. Android 中的音频播放器和音频录制器都有哪些类和接口?它们之间的主要区别是什么?

在 Android 中,音频播放器和音频录制器都有以下类和接口:

音频播放器(Audio Playback):

MediaPlayer:MediaPlayer 类是一个高级的音视频播放器,提供了播放音频和视频的功能。它封装了底层的音视频处理和控制,提供了更高层次的接口和方法,支持播放本地和网络上的音频文件。

AudioTrack:AudioTrack 类用于播放音频数据。它提供了创建和管理音频输出的功能,可以将音频数据写入音频输出设备(如扬声器或耳机)。通过设置采样率、声道数、音频格式等参数,可以实现音频的播放。

音频录制器(Audio Recording):

- AudioRecord:AudioRecord 类用于录制音频数据。它提供了从音频输入设备(如麦克风)读取音频数据的功能。可以设置采样率、声道数、音频格式等参数,并使用缓冲区进行音频数据的处理和读取。

主要区别:

功能不同:音频播放器用于播放音频数据,而音频录制器用于录制音频数据。

数据方向不同:音频播放器从应用程序向音频输出设备发送音频数据,使其播放出来,而音频录制器从音频输入设备读取音频数据,使应用程序可以进行处理或保存。

使用场景不同:音频播放器常用于播放音乐、语音通话等应用,而音频录制器常用于语音录制、音频采集等应用。

相关类和接口不同:音频播放器主要使用 MediaPlayer 和 AudioTrack 类,而音频录制器主要使用 AudioRecord 类。

需要注意的是,MediaPlayer 类是一个更高级的音视频播放器,它提供了更多的功能和灵活性,但也更复杂。AudioTrack 类和 AudioRecord 类则更加底层,提供了更直接的音频数据处理能力。选择使用哪个类取决于具体的需求和应用场景。

10. 如何在 Android 应用程序中播放音频文件?请描述播放音频的基本步骤和使用哪些类和方法。

在 Android 应用程序中播放音频文件的基本步骤如下:

准备音频文件:首先,确保你的应用程序包含要播放的音频文件。可以将音频文件放在 res/raw 目录下或者指定一个文件路径。

创建 MediaPlayer 对象:使用 MediaPlayer 类来播放音频文件。创建一个新的 MediaPlayer 对象,并设置要播放的音频源。

设置音频源:通过调用 MediaPlayer 的 setDataSource() 方法,设置要播放的音频文件的数据源。可以传入文件路径、文件描述符、URL 或 ContentProvider 的 URI。

准备音频:在播放之前,需要调用 MediaPlayer 的 prepare() 或 prepareAsync() 方法来准备音频。prepare() 方法会阻塞当前线程直到音频准备完成,而 prepareAsync() 方法会在后台线程中准备音频,不会阻塞主线程。

开始播放:当音频准备完成后,调用 MediaPlayer 的 start() 方法开始播放音频。

监听播放完成:如果需要监听音频播放完成的事件,可以设置 MediaPlayer 的 OnCompletionListener,然后实现 onCompletion() 方法来处理完成事件。

停止播放:如果需要停止音频播放,可以调用 MediaPlayer 的 stop() 方法。

释放资源:当音频播放完成或不再需要时,应调用 MediaPlayer 的 release() 方法释放资源。

使用的类和方法:

- MediaPlayer 类:用于播放音频文件,提供了控制音频播放的方法,如 setDataSource()、prepare()、start()、stop() 等。

- MediaPlayer.OnCompletionListener 接口:用于监听音频播放完成的事件。

- AudioManager 类:用于管理音频相关的操作,如调整音量、请求音频焦点等。

示例代码如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

MediaPlayer mediaPlayer = new MediaPlayer();

mediaPlayer.setDataSource(filePath); // 设置音频文件路径

mediaPlayer.prepare(); // 准备音频

mediaPlayer.start(); // 开始播放

mediaPlayer.setOnCompletionListener(new MediaPlayer.OnCompletionListener() {

@Override

public void onCompletion(MediaPlayer mp) {

// 处理播放完成事件

}

});

// 停止播放

mediaPlayer.stop();

// 释放资源

mediaPlayer.release();

需要注意的是,上述代码仅为基本示例,实际使用中还可以添加错误处理、状态监听等逻辑。

11. 如何实现音频的录制功能?请描述录制音频的基本步骤和使用哪些类和方法。

实现音频录制功能的基本步骤如下:

创建 AudioRecord 对象:使用 AudioRecord 类来录制音频。创建一个新的 AudioRecord 对象,并设置音频源、采样率、声道配置和音频格式等参数。

分配音频缓冲区:为音频数据分配一个缓冲区,用于存储从音频输入设备读取的音频数据。需要根据音频参数计算缓冲区的大小,并使用 ByteBuffer 或数组作为缓冲区。

开始录制:调用 AudioRecord 的 startRecording() 方法开始录制音频。此时,音频数据会从音频输入设备读取到缓冲区中。

读取音频数据:循环读取缓冲区中的音频数据,并进行相应的处理,例如保存到文件或进行实时处理。

停止录制:当录制完成或不再需要时,调用 AudioRecord 的 stop() 方法停止录制音频。

释放资源:当录制完成后,需要调用 AudioRecord 的 release() 方法释放资源。

使用的类和方法:

- AudioRecord 类:用于录制音频数据,提供了设置音频参数、开始录制、停止录制等方法。

- ByteBuffer 类或数组:用作音频数据的缓冲区,用于存储从音频输入设备读取的音频数据。

示例代码如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

int audioSource = MediaRecorder.AudioSource.MIC; // 音频源为麦克风

int sampleRate = 44100; // 采样率为 44100Hz

int channelConfig = AudioFormat.CHANNEL_IN_MONO; // 单声道

int audioFormat = AudioFormat.ENCODING_PCM_16BIT; // 16 位 PCM 编码

int bufferSize = AudioRecord.getMinBufferSize(sampleRate, channelConfig, audioFormat);

AudioRecord audioRecord = new AudioRecord(audioSource, sampleRate, channelConfig, audioFormat, bufferSize);

byte[] buffer = new byte[bufferSize]; // 音频缓冲区

audioRecord.startRecording(); // 开始录制

while (isRecording) {

int bytesRead = audioRecord.read(buffer, 0, bufferSize); // 读取音频数据

// 处理音频数据,例如保存到文件或进行实时处理

}

audioRecord.stop(); // 停止录制

audioRecord.release(); // 释放资源

需要注意的是,上述代码仅为基本示例,实际使用中还需要进行错误处理、状态管理等逻辑。另外,由于音频数据的处理方式各异,可以根据实际需求进行相应的处理操作。

12. 什么是音频编解码(Audio Encoding/Decoding)?Android 中支持哪些音频编解码器?请举例说明如何使用音频编解码器进行编解码操作。

音频编解码(Audio Encoding/Decoding)是指将音频数据从一种格式(编码)转换为另一种格式(解码)的过程。编码是将原始音频信号转换为数字化的表示形式,而解码则是将数字化的音频数据还原为原始音频信号。

Android 提供了一些常用的音频编解码器,包括:

- AMR-NB(Adaptive Multi-Rate Narrowband):窄带自适应多速率编解码器,常用于电话语音通话。

- AAC(Advanced Audio Coding):高级音频编码,广泛用于音乐和多媒体应用。

- MP3(MPEG-1 Audio Layer 3):流行的音频压缩格式,用于音乐和媒体文件。

- FLAC(Free Lossless Audio Codec):无损音频编解码器,提供无损压缩和解压缩功能。

- PCM(Pulse Code Modulation):脉冲编码调制,一种无损音频编码格式。

下面以使用 Android 中的 MediaCodec 类进行音频编解码操作为例:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

// 创建编码器

MediaCodec encoder = MediaCodec.createEncoderByType("audio/mp4a-latm");

MediaFormat encoderFormat = MediaFormat.createAudioFormat("audio/mp4a-latm", sampleRate, channelCount);

encoderFormat.setInteger(MediaFormat.KEY_BIT_RATE, bitRate);

encoderFormat.setInteger(MediaFormat.KEY_AAC_PROFILE, MediaCodecInfo.CodecProfileLevel.AACObjectLC);

encoder.configure(encoderFormat, null, null, MediaCodec.CONFIGURE_FLAG_ENCODE);

encoder.start();

// 创建解码器

MediaCodec decoder = MediaCodec.createDecoderByType("audio/mp4a-latm");

MediaFormat decoderFormat = MediaFormat.createAudioFormat("audio/mp4a-latm", sampleRate, channelCount);

decoder.configure(decoderFormat, null, null, 0);

decoder.start();

// 编码过程

while (hasDataToEncode) {

// 从音频输入源获取原始音频数据

byte[] inputBuffer = getInputData();

int inputBufferIndex = encoder.dequeueInputBuffer(timeout);

if (inputBufferIndex >= 0) {

ByteBuffer inputBuffer = encoder.getInputBuffer(inputBufferIndex);

inputBuffer.clear();

inputBuffer.put(inputBuffer);

encoder.queueInputBuffer(inputBufferIndex, 0, inputBuffer.length, presentationTimeUs, 0);

}

// 解码过程

int outputBufferIndex = decoder.dequeueOutputBuffer(bufferInfo, timeout);

if (outputBufferIndex >= 0) {

ByteBuffer outputBuffer = decoder.getOutputBuffer(outputBufferIndex);

// 处理解码后的音频数据

decoder.releaseOutputBuffer(outputBufferIndex, false);

}

}

// 停止编解码器并释放资源

encoder.stop();

encoder.release();

decoder.stop();

decoder.release();

需要注意的是,上述代码仅为示例,实际使用时还需要进行错误处理、音频格式设置等操作,具体使用的编解码器和参数需要根据实际情况进行调整。

13. Android 提供了哪些音频效果和音频处理功能?例如,回声消除、噪声抑制、均衡器等。请举例说明如何应用这些音频效果。

Android 提供了一些内置的音频效果和音频处理功能,可以通过 AudioEffect 类和相关类来应用这些效果。以下是一些常见的音频效果和其应用示例:

- 均衡器(Equalizer):用于调整音频信号的频率响应,改变音频的音色和平衡。

1

2

3

4

5

6

7

Equalizer equalizer = new Equalizer(priority, audioSessionId);

equalizer.setEnabled(true);

// 设置频谱区域的增益值

short band = 0; // 频谱区域索引

short gain = 1000; // 增益值

equalizer.setBandLevel(band, gain);

- 回声消除(Acoustic Echo Cancellation):用于消除音频信号中的回声,提高通话质量。

1

2

3

4

AcousticEchoCanceler echoCanceler = AcousticEchoCanceler.create(audioSessionId);

if (AcousticEchoCanceler.isAvailable()) {

echoCanceler.setEnabled(true);

}

- 噪声抑制(Noise Suppression):用于降低音频信号中的背景噪声,提升音频质量。

1

2

3

4

NoiseSuppressor noiseSuppressor = NoiseSuppressor.create(audioSessionId);

if (NoiseSuppressor.isAvailable()) {

noiseSuppressor.setEnabled(true);

}

- 自动增益控制(Automatic Gain Control):用于自动调整音频信号的增益,平衡音频的音量。

1

2

3

4

AutomaticGainControl automaticGainControl = AutomaticGainControl.create(audioSessionId);

if (AutomaticGainControl.isAvailable()) {

automaticGainControl.setEnabled(true);

}

以上仅是部分音频效果和处理功能的示例,具体的应用场景和参数设置需要根据实际需求进行调整。此外,还可以通过使用 MediaPlayer 和 AudioTrack 等类提供的 setAuxEffectSendLevel() 方法将音频效果应用到特定的音频播放器或音频输出上。

14. 请解释 Android 中的音频路由(Audio Routing)是什么,并举例说明如何控制音频的路由。

音频路由(Audio Routing)是指确定音频信号的传输路径和目的地的过程。在 Android 中,音频路由用于控制音频信号的输出方式,例如是通过扬声器、耳机、蓝牙设备还是其他音频输出设备播放。

Android 提供了 AudioManager 类来管理音频路由。以下是一些常见的音频路由控制示例:

- 切换到扬声器(Speaker)输出:

1 2 3

AudioManager audioManager = (AudioManager) getSystemService(Context.AUDIO_SERVICE); audioManager.setMode(AudioManager.MODE_NORMAL); audioManager.setSpeakerphoneOn(true);

- 切换到耳机(Headphones)输出:

1 2

AudioManager audioManager = (AudioManager) getSystemService(Context.AUDIO_SERVICE); audioManager.setWiredHeadsetOn(true);

- 切换到蓝牙(Bluetooth)输出:

1 2 3 4

AudioManager audioManager = (AudioManager) getSystemService(Context.AUDIO_SERVICE); audioManager.setMode(AudioManager.MODE_NORMAL); audioManager.startBluetoothSco(); audioManager.setBluetoothScoOn(true);

需要注意的是,音频路由的控制还涉及到音频焦点(Audio Focus)的管理,以确保正确的音频输出目标和优先级。

此外,还可以使用音频回调接口(例如 AudioManager.OnAudioFocusChangeListener)来监听音频路由的变化,并根据需要进行相应的操作。例如,当耳机插入或断开时,可以接收到音频路由变化的回调,然后更新音频输出设置。

15. 音频延迟对于实时应用程序(如语音通话、游戏)非常重要。在 Android 中,如何测量和降低音频延迟?

在 Android 中测量和降低音频延迟是关键,特别是对于实时应用程序。以下是一些在 Android 中测量和降低音频延迟的方法:

- 使用 AudioRecord 和 AudioTrack 测量延迟:

- 创建一个 AudioRecord 实例用于录制音频,同时创建一个 AudioTrack 实例用于播放音频。

- 使用一个定时器或计时器,在录制音频时记录时间戳,并在播放音频时再次记录时间戳。

- 计算录制和播放之间的时间差,即为音频延迟。

- 使用 OpenSL ES(Open Sound Library for Embedded Systems)进行低延迟音频处理:

- OpenSL ES 是 Android 提供的一种底层音频库,可以实现低延迟的音频处理。

- 使用 OpenSL ES,可以直接访问底层音频硬件,减少了中间层的延迟。

- 通过优化音频数据处理的算法和线程间通信,可以进一步降低音频延迟。

- 优化音频流程和线程管理:

- 在音频处理过程中,合理管理线程和处理流程,避免阻塞和延迟。

- 使用专用的音频线程进行音频数据的采集、处理和播放,以确保实时性。

- 避免在音频处理线程中执行耗时的操作,如文件读写、网络请求等。

- 避免额外的音频处理和转换:

- 减少对音频数据的额外处理和转换,尽量保持原始音频数据的格式和采样率。

- 避免频繁的音频格式转换和采样率转换,以减少延迟和处理开销。

- 使用硬件加速和优化:

- 利用硬件加速功能,如硬件解码和编码器,可以减少音频处理的延迟。

- 优化音频缓冲区的大小和填充策略,以提高数据的传输效率和实时性。

需要注意的是,音频延迟受到多个因素的影响,包括硬件设备、操作系统、音频处理算法等。因此,综合考虑以上方法并进行适当的调试和优化,可以帮助测量和降低音频延迟,以实现更好的实时应用体验。

16. Android 中如何处理音频焦点冲突?如果应用程序正在播放音频而另一个应用程序请求音频焦点,该怎么办?

在 Android 中,处理音频焦点冲突是很重要的,可以通过以下方式来处理:

- 实现 AudioManager.OnAudioFocusChangeListener 接口:

- 通过实现 OnAudioFocusChangeListener 接口,可以监听音频焦点的变化。

- 在 onAudioFocusChange() 回调方法中处理焦点变化的情况。

- 请求音频焦点:

- 在需要播放音频之前,通过 AudioManager 的 requestAudioFocus() 方法请求音频焦点。

- 需要指定焦点类型、焦点变化时的处理方式以及音频焦点请求的时长。

- 处理音频焦点变化:

- 在 onAudioFocusChange() 方法中根据焦点变化的情况采取适当的操作。

- 例如,当失去焦点时停止音频播放或降低音量,当重新获得焦点时恢复播放或增加音量。

- 处理焦点冲突:

- 当另一个应用程序请求音频焦点时,会触发 onAudioFocusChange() 方法。

- 在处理焦点冲突时,可以根据不同的焦点请求类型和优先级来确定适当的行为。

- 例如,如果当前应用程序的音频是短暂的提示音,则可以暂停当前的音频播放并播放提示音。

- 释放音频焦点:

- 当应用程序不再需要音频焦点时,应使用 AudioManager 的 abandonAudioFocus() 方法释放焦点。

需要注意的是,不同类型的焦点请求具有不同的优先级。例如,使用 AudioManager.AUDIOFOCUS_GAIN 类型请求的焦点具有较高的优先级,而 AudioManager.AUDIOFOCUS_GAIN_TRANSIENT 类型请求的焦点则较低。因此,在处理焦点冲突时,需要考虑焦点请求的优先级来决定适当的行为。

17. 什么是音频混音(Audio Mixing)?Android 中如何实现多个音频源的混音?

音频混音是指将多个音频源的声音信号合并成一个单一的音频输出。在 Android 中,可以使用 AudioTrack 类来实现多个音频源的混音。

下面是实现音频混音的基本步骤:

- 创建多个 AudioTrack 对象:

- 需要为每个音频源创建一个独立的 AudioTrack 对象。

- 每个 AudioTrack 对象表示一个音频源,可以设置其音频参数和缓冲区大小。

- 读取音频数据:

- 从每个音频源中读取音频数据,可以是 PCM 格式的原始音频数据或解码后的音频数据。

- 可以使用 AudioTrack 的 write() 方法将音频数据写入各自的缓冲区。

- 设置音量:

- 根据需要,可以通过设置每个 AudioTrack 对象的音量来调整各个音频源的音量。

- 可以使用 AudioTrack 的 setStereoVolume() 方法设置音量。

- 混音处理:

- 通过循环遍历所有音频源的缓冲区,从每个缓冲区中读取相应的音频数据,并将其相加或平均计算。

- 将混合后的音频数据写入最终的 AudioTrack 对象的缓冲区。

- 播放混音音频:

- 最终的 AudioTrack 对象表示混合后的音频源。

- 使用该对象的 play() 方法开始播放混音音频。

需要注意的是,音频混音涉及实时处理和同步操作,因此需要合理管理音频数据的读取和处理速度,以确保音频的实时性和质量。此外,还要注意处理音频数据的格式和采样率的一致性,以避免音频失真或不匹配的问题。

18. 在 Android 中,如何实现音频的跨应用共享?例如,一个应用程序可以播放音频,而另一个应用程序可以接收并处理该音频。

在 Android 中,实现音频的跨应用共享可以使用 MediaProjection 和 MediaProjectionManager 这两个类。

- 首先,获取 MediaProjection 对象:

- 使用 MediaProjectionManager 的 createScreenCaptureIntent() 方法创建一个 Intent。

- 将 Intent 发送给另一个应用程序,该应用程序需要请求屏幕捕获权限。

- 一旦权限被授予,另一个应用程序将获取到一个 MediaProjection 对象。

- 将音频数据发送给另一个应用程序:

- 在源应用程序中,使用 AudioRecord 类录制音频数据。

- 在每次录制到的音频数据可用时,将其发送给目标应用程序。

- 可以通过网络套接字、共享内存等方式将音频数据传输给目标应用程序。

- 在目标应用程序中接收和处理音频数据:

- 在目标应用程序中,接收来自源应用程序的音频数据。

- 使用 AudioTrack 类播放接收到的音频数据。

需要注意的是,音频的跨应用共享涉及到应用程序之间的协作和数据传输,因此需要在源应用程序和目标应用程序之间建立合适的通信机制和协议,以确保音频数据的传输和处理的正确性和实时性。此外,还要考虑音频数据的编解码和格式的一致性,以避免音频失真或不匹配的问题。

19. Android 提供了哪些音频格式支持?如何在应用程序中识别和处理不同的音频格式?

Android 提供了广泛的音频格式支持,包括但不限于以下几种常见的音频格式:

PCM (Pulse Code Modulation):原始音频数据的编码格式,可以是 16 位或 8 位的单声道或立体声数据。

AAC (Advanced Audio Coding):一种高效的音频编码格式,常用于音频传输和存储。

MP3 (MPEG-1 Audio Layer III):一种常见的有损压缩音频格式,广泛应用于音乐播放和音频传输。

FLAC (Free Lossless Audio Codec):一种无损音频编码格式,保留了原始音频数据的质量。

OGG (Ogg Vorbis):一种开放的无损音频编码格式,常用于音乐存储和网络传输。

MIDI (Musical Instrument Digital Interface):一种用于音乐乐器之间通信的音频格式,包含音符、乐器和控制信息。

在应用程序中识别和处理不同的音频格式,可以借助 Android 提供的媒体框架和相关类库,如 MediaExtractor、MediaCodec、MediaPlayer 等。以下是一般的步骤:

使用 MediaExtractor 类提取音频文件的音轨信息。可以使用 setDataSource() 方法设置音频文件路径,并使用 getTrackFormat() 方法获取音轨的格式。

根据音频格式,选择合适的解码器进行解码。使用 MediaCodec 类来创建解码器,并将音频格式信息传递给解码器。

配置解码器的输入和输出缓冲区。使用 MediaCodec 的 getInputBuffers() 和 getOutputBuffers() 方法获取输入和输出缓冲区。

从输入缓冲区读取音频数据,并将其传递给解码器进行解码。

解码后的音频数据可以直接播放,或进行后续处理、存储等操作。

需要根据特定的音频格式和处理需求,选择适当的解码器和处理流程。可以通过监听解码器的状态和回调来实时获取解码进度和处理结果,以便进行相应的处理和操作。

20. 如何在 Android 应用程序中实现音频的实时处理和实时效果?

在 Android 应用程序中实现音频的实时处理和实时效果可以通过以下步骤实现:

获取音频数据:使用 Android 的音频录制功能获取实时的音频数据。可以使用 AudioRecord 类来设置音频源、采样率、音频格式等参数,并通过 read() 方法读取实时音频数据。

音频处理:对获取到的音频数据进行实时处理。可以使用 Android 提供的音频处理库,如 AudioEffect、AudioTrack 等,或者使用第三方库进行音频处理操作。根据需求,可以实现音频增益、均衡器、混响、变声等效果。

实时效果应用:将处理后的音频数据应用到音频播放中。使用 AudioTrack 类来播放处理后的音频数据。可以使用 setPlaybackRate() 方法设置采样率,使用 write() 方法将音频数据写入 AudioTrack 的缓冲区,并使用 play() 方法开始播放。

监控和调整:实时处理和效果应用后,可以进行监控和调整以满足需求。可以通过监听录制和播放进度、实时监测音频数据的声音强度等信息,以便进行动态调整和优化。

需要注意的是,在实时处理和实时效果应用时,要考虑到音频数据的处理延迟。较大的处理延迟可能会导致音频不同步或延迟的感知。因此,需要仔细调整和优化音频处理流程,以减少处理延迟并提供良好的实时性能。

另外,对于实时音频处理和实时效果应用,也要考虑手机的性能和处理能力,避免过度消耗系统资源导致卡顿或影响其他功能的正常运行。

21. 请解释 Android 中的音频回放(Audio Playback)和音频流(Audio Stream)之间的区别和联系。

在 Android 中,音频回放(Audio Playback)和音频流(Audio Stream)是两个相关但不同的概念。

音频回放指的是从设备的音频输出(如扬声器或耳机)播放音频数据的过程。它涉及将音频数据传递给音频硬件并通过扬声器或耳机进行播放,以供用户听到声音。音频回放通常用于播放音乐、视频、游戏音效等。

音频流指的是在 Android 系统中对音频数据进行管理和控制的逻辑概念。每个音频流都代表了一个特定类型的音频数据流,例如音乐、通话、通知、闹钟等。Android 提供了不同的音频流,每个音频流都具有不同的属性和行为,例如音量控制、焦点管理、通道配置等。

在 Android 中,音频回放和音频流之间存在以下联系和关系:

音频回放是通过音频流实现的:音频回放是基于音频流的概念实现的。当应用程序执行音频回放时,它会选择一个适当的音频流来传递音频数据,并根据音频流的属性和配置来控制音频的行为。

音频回放受音频流的控制:音频回放的行为受音频流的控制。例如,音频流的音量控制会影响音频回放的音量级别,音频流的焦点管理会影响音频回放在不同焦点状态下的行为。

多个音频回放可以共享同一音频流:多个应用程序或组件可以共享同一音频流进行音频回放。这意味着它们可以共享相同的音量、焦点和其他属性,以便协调不同应用程序之间的音频回放。

总结起来,音频回放是指从设备的音频输出播放音频数据的过程,而音频流是 Android 系统中对音频数据进行管理和控制的逻辑概念。音频回放通过选择和操作适当的音频流来实现,并受音频流的控制和属性影响。

22. Android 中的音频通道(Audio Channel)是什么?不同的音频通道有什么作用?

在 Android 中,音频通道(Audio Channel)是用于控制音频输出的逻辑概念。它定义了音频数据在播放时的目标输出位置或路由。

不同的音频通道在音频数据的输出位置和设备上有不同的作用。以下是 Android 中常见的音频通道及其作用:

STREAM_VOICE_CALL(通话):用于手机通话音频的通道,将音频数据路由到电话听筒或扬声器。

STREAM_SYSTEM(系统音频):用于系统音频效果、按键声音等的通道,将音频数据路由到扬声器。

STREAM_RING(铃声):用于来电铃声的通道,将音频数据路由到扬声器。

STREAM_MUSIC(音乐):用于媒体音乐的通道,将音频数据路由到扬声器或耳机。

STREAM_ALARM(闹钟):用于闹钟音频的通道,将音频数据路由到扬声器。

STREAM_NOTIFICATION(通知):用于应用程序通知音频的通道,将音频数据路由到扬声器。

STREAM_DTMF(双音多频):用于拨号按键音效的通道,将音频数据路由到扬声器。

每个音频通道都有自己的音量控制和行为属性。例如,系统通道(STREAM_SYSTEM)的音量可以通过系统音量键进行控制,铃声通道(STREAM_RING)的音量可以受到来电铃声模式和振动模式的影响。音频通道的使用可以帮助应用程序适当地将音频数据路由到特定的输出位置,以提供更好的用户体验。

需要注意的是,音频通道的具体行为可能因设备和 Android 版本的不同而有所差异。在开发应用程序时,可以根据具体需求和用户体验考虑选择适当的音频通道来播放音频数据。

23. Android 中的音频事件(Audio Events)是什么?可以举例说明几种常见的音频事件。

在 Android 中,音频事件(Audio Events)是指与音频相关的系统事件或状态变化,应用程序可以注册侦听器来接收这些事件并做出相应的处理。这些事件提供了对音频会话、音频焦点和音频设备状态等方面的监听和响应机制。

以下是几种常见的音频事件:

音频焦点事件(Audio Focus Events):当其他应用程序请求音频焦点时,当前应用程序可能会收到音频焦点丢失的事件通知。例如,来电时,当前正在播放音乐的应用程序可能会丢失音频焦点,从而触发音频焦点丢失事件。应用程序可以在收到音频焦点丢失事件后暂停或停止音频播放。

音频设备状态事件(Audio Device State Events):当连接或断开外部音频设备(如耳机或蓝牙音箱)时,应用程序可能会收到音频设备状态变化的事件通知。例如,当用户插入耳机时,应用程序可以收到音频设备连接事件,并相应地调整音频的输出路由。

音频会话事件(Audio Session Events):当与音频会话相关的状态发生变化时,应用程序可能会收到音频会话事件。例如,当与特定音频会话关联的音频输入或输出设备发生变化时,应用程序可以收到相应的音频会话事件,以便进行适当的处理。

音频焦点转移事件(Audio Focus Transfer Events):当其他应用程序请求音频焦点并成功获得焦点时,当前应用程序可能会收到音频焦点转移事件通知。这表示当前应用程序已经失去音频焦点,并且另一个应用程序已经获得了焦点。应用程序可以根据需要对音频焦点转移事件作出响应。

这些音频事件提供了对音频系统状态变化的感知和响应机制,使应用程序能够根据需要调整音频播放行为、处理设备连接或断开、处理音频焦点的转移等情况。通过注册相应的事件侦听器,应用程序可以灵活地处理这些事件,并提供更好的用户体验。

24. Android 中的音频录制和播放涉及到的底层音频硬件是什么?如何与音频硬件进行交互?

在 Android 中,音频录制和播放涉及到的底层音频硬件是麦克风和扬声器(或耳机)。

Android 提供了一套音频框架和 API,用于与底层音频硬件进行交互。以下是与音频硬件交互的主要组件和过程:

AudioRecord(音频录制):AudioRecord 类用于从麦克风或其他音频源录制音频数据。通过指定录制参数(例如采样率、声道数和音频格式),应用程序可以创建一个 AudioRecord 实例,并使用其提供的方法开始录制音频。录制的音频数据可以通过缓冲区进行处理和读取。

AudioTrack(音频播放):AudioTrack 类用于将音频数据播放到扬声器或耳机。应用程序可以创建一个 AudioTrack 实例,并通过提供音频参数和缓冲区来初始化它。然后,可以使用 AudioTrack 的方法将音频数据写入缓冲区,并调用播放方法开始音频播放。

AudioManager(音频管理):AudioManager 类提供了对音频系统的控制和管理。它可以用于获取和设置音频属性,如音量控制、音频模式和音频路由。通过 AudioManager,应用程序可以管理音频会话、请求音频焦点以及处理与音频设备状态相关的事件。

AudioAttributes(音频属性):AudioAttributes 类用于指定音频数据的属性,如音频流类型(STREAM_MUSIC、STREAM_VOICE_CALL 等)、音频用途(USAGE_MEDIA、USAGE_VOICE_COMMUNICATION 等)和音频标志(FLAG_AUDIBILITY_ENFORCED 等)。这些属性可用于配置和定义音频数据的特性,以便系统正确处理和路由音频。

通过这些音频组件和 API,Android 应用程序可以与底层音频硬件进行交互,实现音频录制和播放的功能。应用程序可以根据需要配置音频参数、管理音频会话、控制音频焦点,以及处理与音频硬件和系统相关的事件。

25. 在 Android 中如何处理音频延迟和音频时钟同步的问题?

音频延迟和音频时钟同步是实时音频应用程序中的重要问题。Android 提供了相关的 API(如 getTimestamp() 方法)来测量音频延迟,并提供了 AudioTrack 的 setPlaybackRate() 方法来实现音频时钟同步。 音频性能优化涉及到减少音频延迟、优化音频采样率和编解码器性能、合理管理音频资源等方面。对于音频性能优化,可以考虑以下策略:合理设置音频缓冲区大小、使用适当的音频采样率、优化音频编解码算法、避免频繁的音频资源切换等。

26. Android Framework 中 Binder 在 Audio 模块中的作用

在 Android Framework 中,Binder 在音频模块中起着关键的作用。Binder 是 Android 系统中用于实现跨进程通信(IPC)的机制,它负责在不同的进程之间传递音频相关的请求和数据。

在音频模块中,以下是 Binder 的主要作用:

AudioService 的实现:AudioService 是 Android 系统中负责管理音频功能的核心服务,它提供了音频的控制、路由、音量管理等功能。AudioService 作为一个系统服务,使用 Binder 进行与客户端应用程序之间的通信。客户端应用程序可以通过 Binder 调用 AudioService 提供的接口,来请求音频功能的操作。

跨进程音频操作:由于 Android 应用程序是以进程隔离的方式运行的,音频操作可能涉及到多个进程。通过使用 Binder,音频模块可以提供跨进程的音频操作接口,使不同进程中的应用程序能够访问和控制音频功能。例如,一个应用程序可以使用 Binder 调用另一个进程中的音频服务来播放音频文件。

音频焦点管理:音频焦点是 Android 系统中用于管理应用程序之间的音频播放权的机制。当应用程序请求音频焦点或其他应用程序请求音频焦点时,音频焦点管理需要协调不同进程之间的焦点转移。Binder 可以在音频焦点管理中扮演关键角色,实现进程间的音频焦点转移和通知。

总之,Binder 在音频模块中扮演着实现跨进程音频功能通信的关键角色,它使得音频服务能够提供给不同进程的应用程序使用,并实现了跨进程音频操作和音频焦点管理。

27. AOSP 源码中跟 audio 相关的代码路径

在 AOSP(Android Open Source Project)源码中,与音频相关的代码位于以下路径:

- 框架层(framework):

frameworks/base/media/java/android/media:包含与媒体播放、录制、编解码等相关的类和接口。frameworks/base/media/libmedia:包含媒体库的实现,包括音频播放器、录音机等。frameworks/av:包含音视频相关的框架代码,其中包括音频编解码器、音频效果处理等。

- 硬件抽象层(HAL,Hardware Abstraction Layer):

hardware/libhardware/include/hardware/audio.h:定义了音频硬件抽象层的接口。hardware/libhardware/modules/audio:包含具体的音频硬件模块的实现代码,如音频驱动程序。

- 内核层(kernel):

kernel/sound:包含了 Linux 内核中与音频相关的代码,包括音频驱动程序和音频设备的实现。

需要注意的是,音频相关的代码在 AOSP 中涵盖了多个模块和层次,包括应用框架层、硬件抽象层和内核层。这些代码负责管理音频的播放、录制、编解码、音频效果处理以及与硬件设备的交互等功能。具体的实现细节可以在对应的路径下查找和阅读源码文件。

Comments powered by Disqus.